なぜ大学職員はAIの「セキュリティ」を重要視するか

近年、ChatGPTやGeminiなどの高性能AIツールが事務作業の効率を劇的に向上させています。メール作成、議事録の要約、Excel関数の生成など、その恩恵は計り知れません。

しかし、一部の大学職員の皆様がAIの利用に抵抗感を感じる最大の理由は何でしょうか? それは間違いなく「情報セキュリティの懸念」です。

大学は、学生の個人情報(氏名、学籍番号、成績)、教職員の機密情報、そして将来の研究に繋がる高度な知財情報など、社会的に機密性の高い情報を扱っています。

もし、これらの機密情報を外部のAIに入力し、情報漏洩が発生すれば、大学の信頼は失墜し、重大な危機に直面します。この問題をクリアしなければ、AIによる業務効率化は実現できません。

本記事では、文系・非エンジニアの大学職員が、情報漏洩のリスクを最小限に抑え、実もレベルでAIを安全に活用するための具体的なチェックリストと手順を解説します。

当ブログは現役大学職員の私が、AIツール(Gemini, ChatGPTなど)を活用し、事務業務改善をするためのAI活用ブログです。私自身、文系大学卒の非エンジニアの事務職員なので、専門用語は避けて読者の皆さんが分かりやすく、すぐ使える情報をお届けできるよう心がけています。

プロフィールの詳細は、以下をご覧ください。

AIサービス利用前の必須設定と機能チェック(実務レベル)

大学職員が個人や部署単位でAIを使い始める際、最も手軽に、かつ確実に行うべきセキュリティ対策が「ツールの設定変更」です。以下の3つのチェックポイントは、情報漏洩を防ぐための最低限かつ最優先のポイントとなります。

「データ学習停止機能」の確認と設定(最優先事項)

ほとんどの主要なAIサービスは、ユーザーが入力したデータをAIモデルの性能向上(学習)に使わないよう設定する機能を提供しています。この設定がオフになっていないと、機密性の高い文書や個人情報が将来的に「誰かの質問への回答」として使われるリスクが生じます。

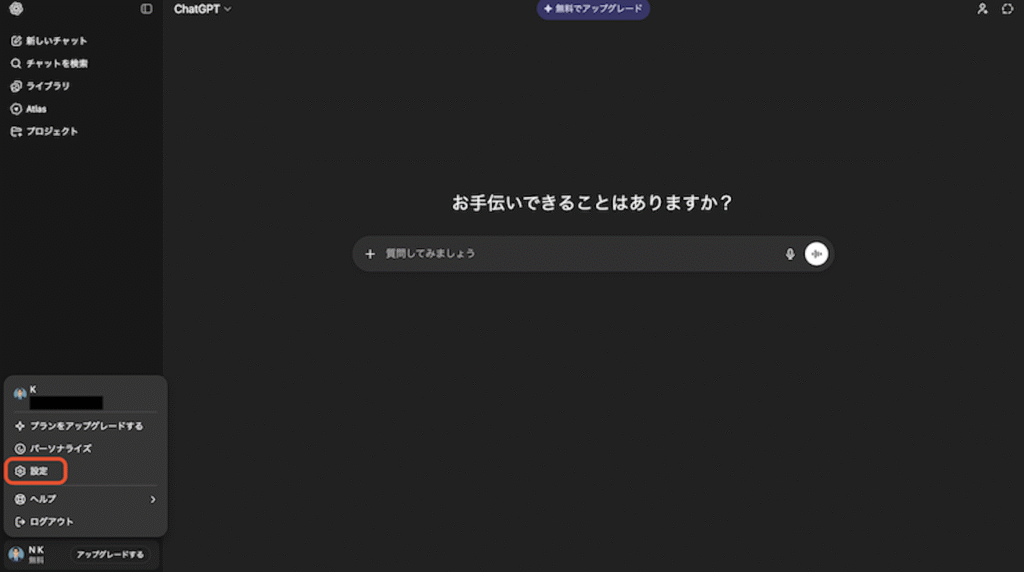

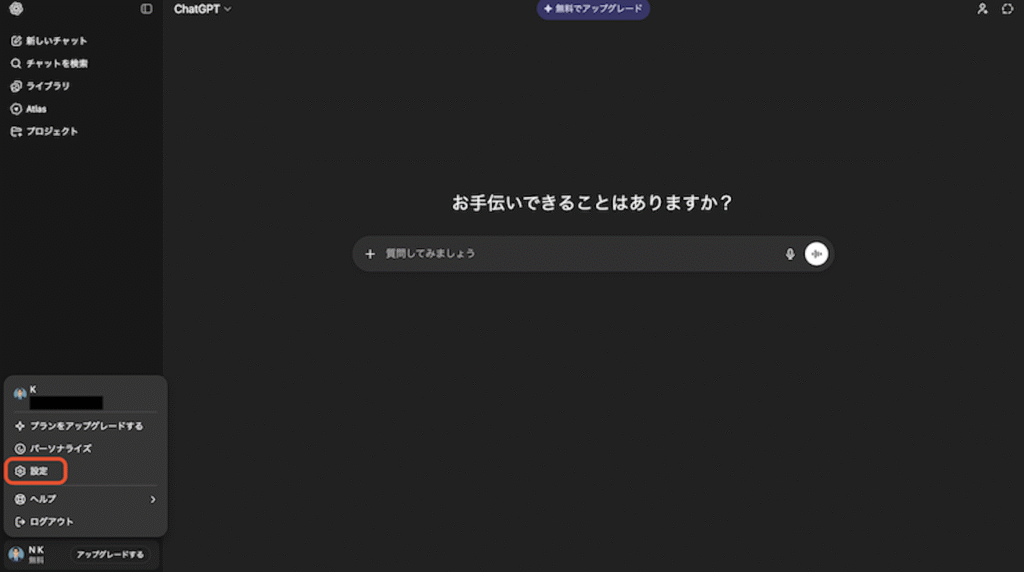

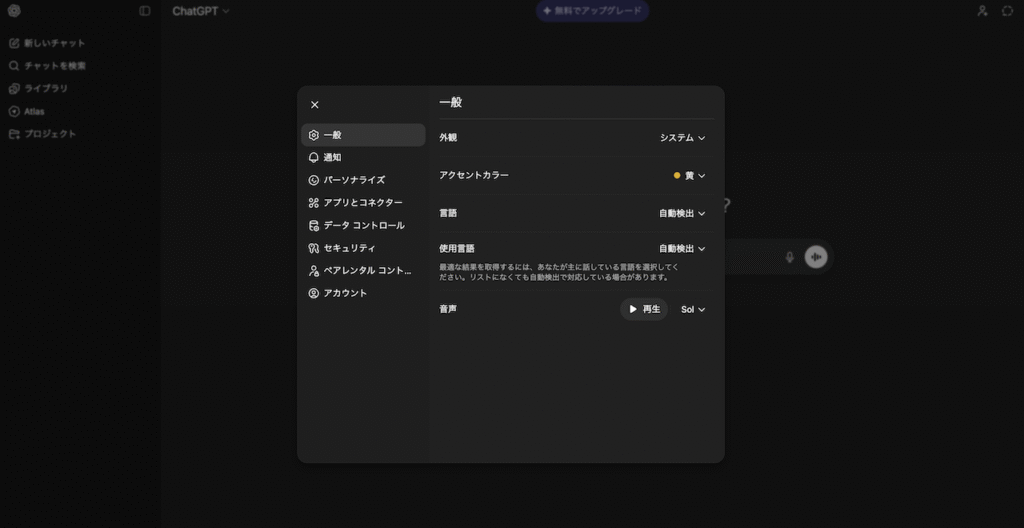

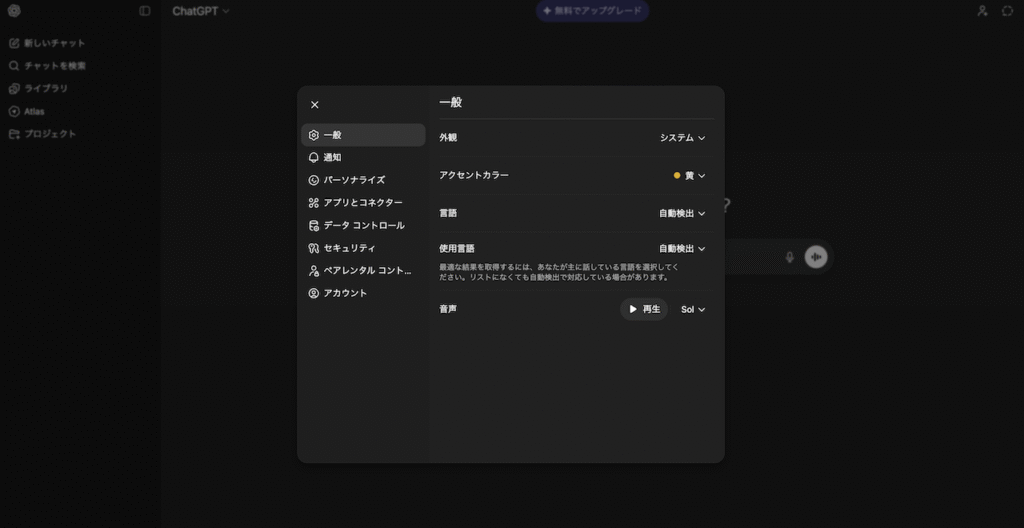

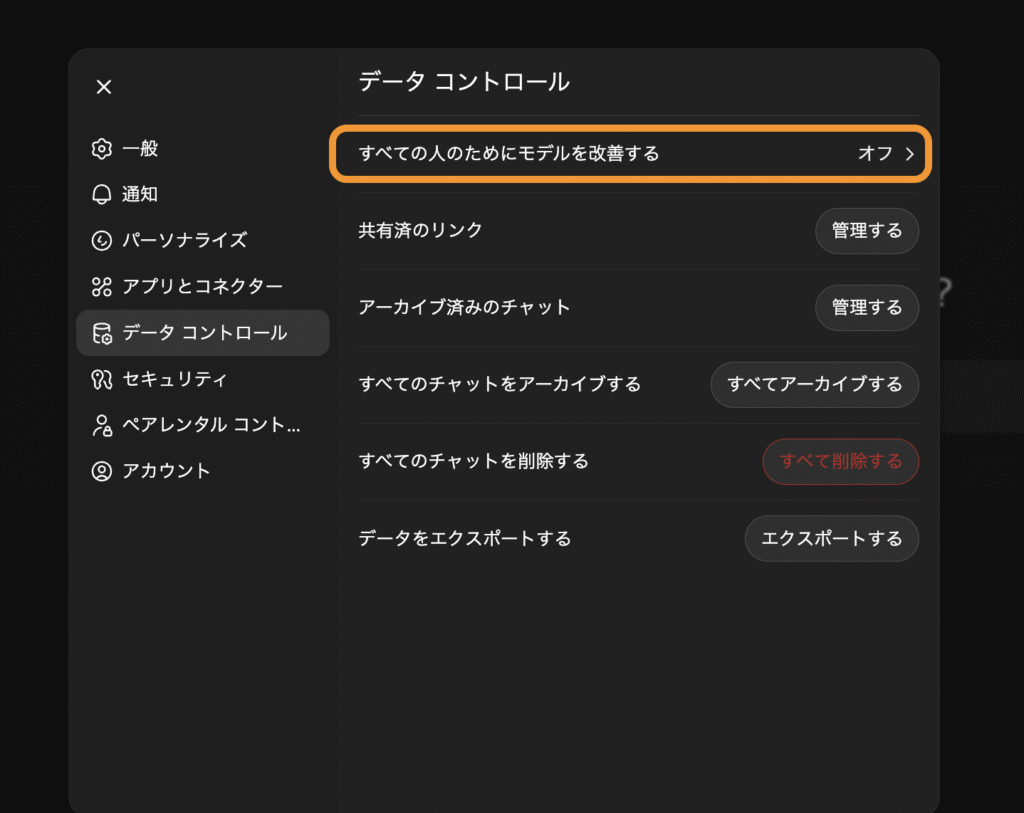

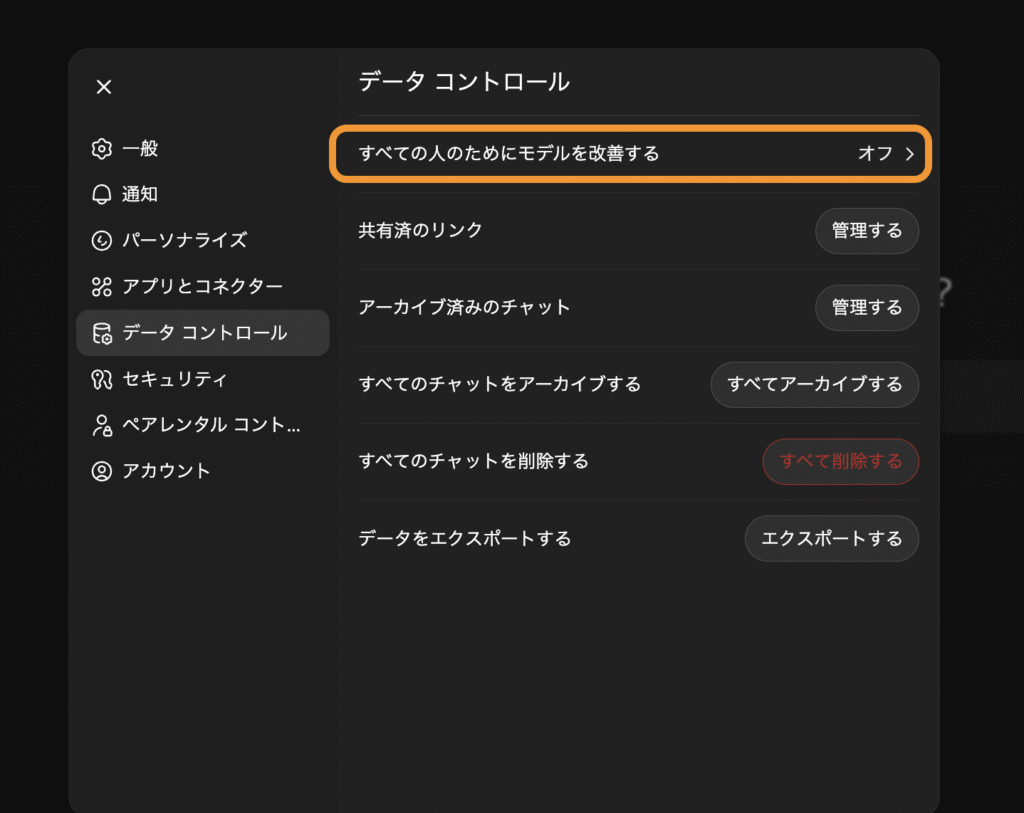

設定の方法:ChatGPTの場合

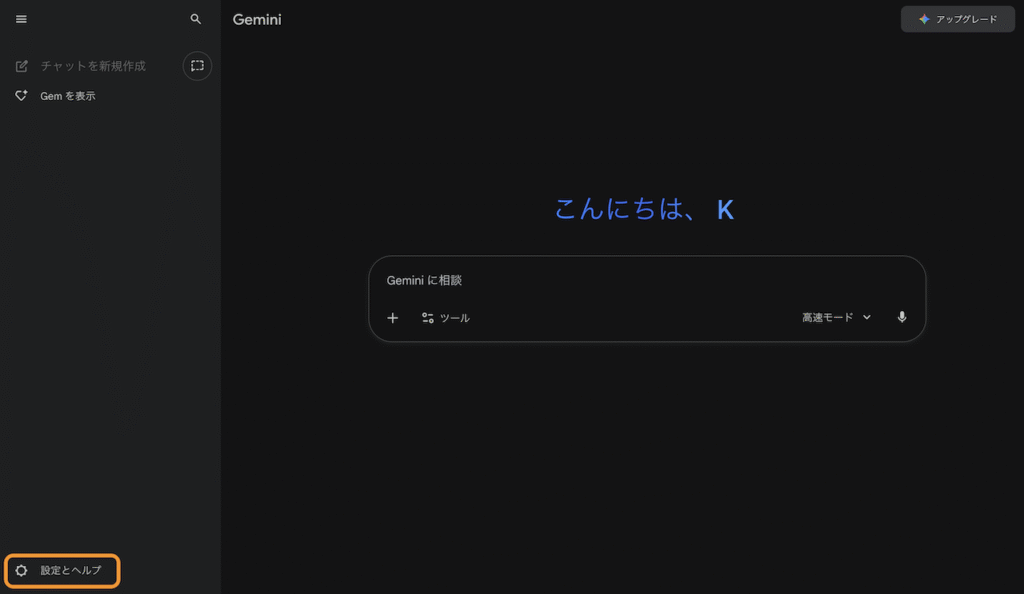

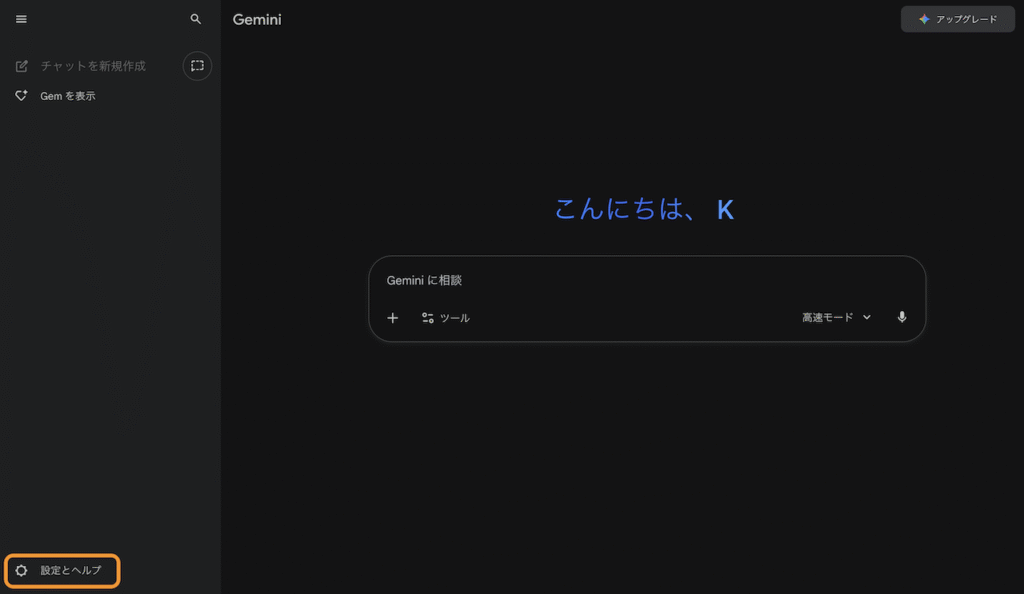

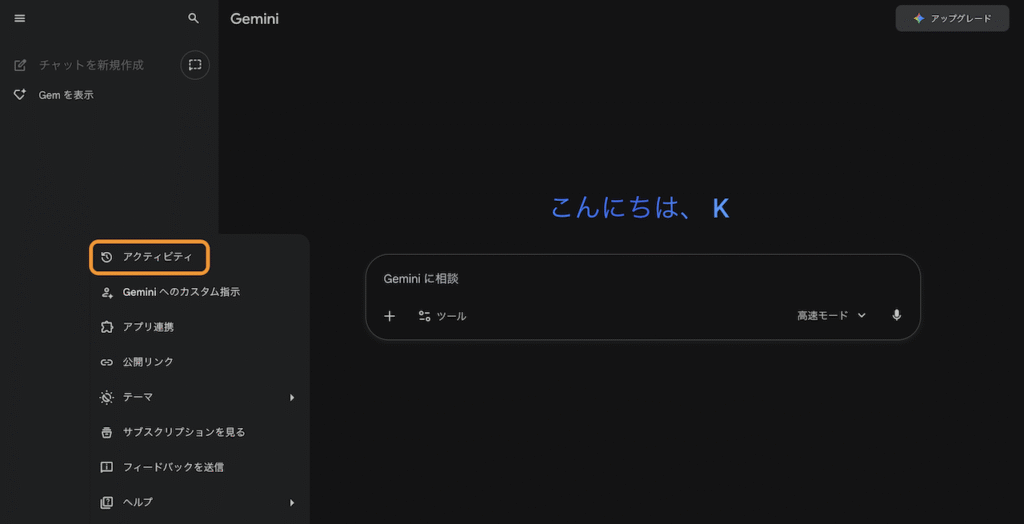

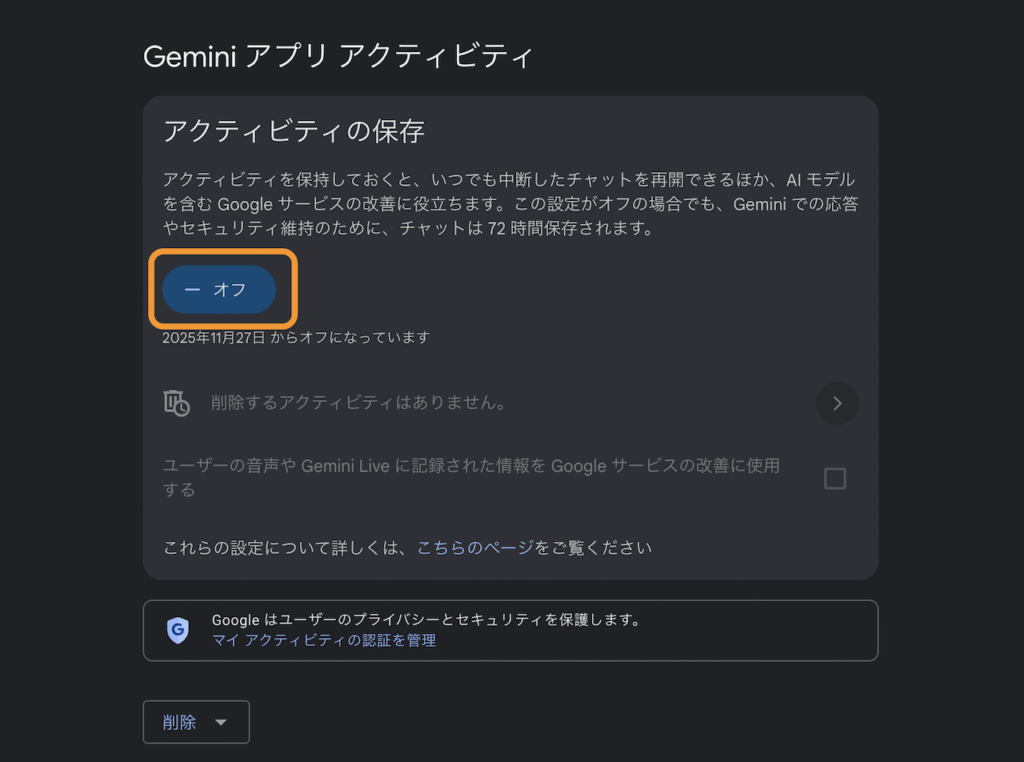

設定の方法:Geminiの場合

【実務上の注意点】

この設定を「オフ」にすると、多くの場合、過去のチャット履歴は保存されなくなります。業務記録として履歴が必要な場合は、学内ルールに基づき、利用後に内容を別途保存する手間が発生します。

ログと利用履歴の「非表示設定」と「自動削除ポリシー」

「データ学習停止」を設定した場合でも、一時的にAIサービス提供者のサーバーにデータが残ることがあります。

法人版を利用する場合: 管理者(情報システム部門)が、誰がいつ何を入力したか「ログ(履歴)」を閲覧・監査できる設定になっているか確認しましょう。これにより、不正な利用や情報漏洩を早期に発見できます。

個人版を利用する場合: 定期的に(例:業務完了後、週に一度など)チャット履歴を手動で削除する「自己管理ルール」を徹底しましょう。

プロンプトに入力する前の「情報マスキング」テクニック

最も安全なセキュリティ対策は、そもそもAIに機密情報を入力しないことです。しかし、業務効率化のためにはどうしても機密文書を要約・校正したい場合があります。

大学職員として必須となる、プロンプトに入力する前の情報マスキング(匿名化)の具体的な手順を身につけてください。

| 目的 | NGな入力例 | OKな入力例(マスキング例) |

| 個人情報を含む文書の要約 | 「学生の山田太郎(学籍番号: 20XX-999)からの休学願を要約して。」 | 「学生の【氏名A・学籍番号X】からの【書類種別】を要約して。」 |

| 内部の機密名称の校正 | 「次期中期計画策定委員会の議事録を校正して。」 | 「【組織名】の議事録を校正して。【組織名】の部分はそのまま維持すること。」 |

| 金額に関する文書の作成 | 「総額3,500万円の予算案について、費用内訳の文章を整えて。」 | 「総額【金額A】円の予算案について、【内訳】の文章を整えて。【金額A】の部分は維持すること。」 |

【実践のポイント】

マスキングには、特定の記号(例:【個人名A】)を一貫して使用してください。

AIへの指示(プロンプト)の冒頭で「【個人名A】は個人情報であるため、出力には含めず、入力文書から変更しないこと」と明確に指示を出すことで、AIによる意図しない情報漏洩リスクを最小限に抑えられます。

情報漏洩を防ぐ!大学のためのセキュリティ・監査チェックリスト10項目

個人の設定だけでなく、組織全体としてAI利用を安全にするために、以下の10項目をチェックし、ガイドラインに組み込みましょう。これは、AIの導入を止めるためではなく、安全な利用を促進するための「監査項目」です。

| No. | チェック項目 | 概要(職員が取るべき具体的な行動) |

| 1 | 利用ツールの承認プロセス | 利用を許可するAIツールを限定し、その承認を学内規定に明記しているか。 |

| 2 | 入力データ限定ポリシー | 「機密レベルに応じたAI入力の可否」を定めているか。(例:レベル1:公開情報のみ可、レベル5:個人情報含む文書は不可) |

| 3 | 部署ごとの利用責任者 | 部署ごとにAI利用の責任者を設置し、セキュリティ意識を徹底しているか。 |

| 4 | 利用ログの定期監査 | 職員のAI利用ログ(利用目的、入力情報など)を月に一度監査する体制があるか。 |

| 5 | AI利用のための専用環境 | 学内ネットワークやVPN経由でのみアクセス可能なクローズドなAI環境(例:Azure OpenAI Serviceなど)を検討しているか。 |

| 6 | 生成された情報のファクトチェック | AIが生成した情報を「必ず人間が確認する」ルールが徹底されているか。 |

| 7 | 職員への定期研修 | AIセキュリティに関する全職員向けの義務研修を実施しているか。 |

| 8 | 不正アクセス対策 | AIアカウントの二要素認証を必須としているか。 |

| 9 | ベンダーの契約内容確認 | 利用するAIベンダーの「データの利用目的」「保管場所」「セキュリティ認証」を確認したか。 |

| 10 | 緊急時対応計画 | 万が一、情報漏洩が発生した場合の報告先・対応手順を明確に定めているか。 |

AIを安全に導入・運用するために(管理者向け)

上記で解説した対策は、AIによる業務効率化を「ゼロ」にしないための基盤です。この基盤を築いた上で、さらに高度なセキュリティと効率を両立させる次のステップに進みましょう。

より安全なAI環境の構築: 外部のAIサービス(LLM)のデータ保護に不安が残る場合は、大学内のサーバーでAIを運用する「オンプレミス型LLM」や、セキュリティが厳重に管理された「プライベートクラウド環境」での利用を検討しましょう。これにより、機密情報が外部に漏れるリスクを限りなくゼロに近づけることが可能になります。

まとめ

AIは私たちの仕事を奪うものではなく、私たちを「面倒な事務作業」から解放してくれる強力なツールです。

しかし、その利便性と引き換えにセキュリティを疎かにしてはいけません。

安全な利用ガイドラインの策定と、本記事のチェックリストに基づいた職員一人ひとりの高い意識こそが、大学におけるAIによる業務効率化への確実な第一歩となります。

コメント